Na semana passada, partindo do documentário O Dilema das Redes (2020), eu discuti, aqui neste espaço, sobre como o racismo se manifesta nas redes sociais. Falei também sobre como os algoritmos são codificados de modo a privilegiar e amplificar o alcance de pessoas brancas e residentes de áreas centrais, ao passo em que silencia pessoas negras e periféricas.

O debate sobre racismo algorítmico movimentou a timeline do Twitter e pôde-se ver linkados diversos estudos sobre os temas, nos mais variados desdobramentos. Um dos ganchos para isso, foram tweets que mostravam que, ao tuitar uma imagem grande contendo um rosto negro e um rosto branco, o algoritmo do Twitter identificava o rosto branco como a parte “mais importante” da imagem, dando a ela o destaque na miniatura. Ainda que se invertessem as posições dos rostos na imagem ou aumentassem a quantidade de rostos negros, o destaque continuaria sendo direcionado ao busto branco.

A discussão maior se deu a respeito de como as redes sociais sabotam o conteúdo produzido por pessoas negras e/ou que contém pessoas negras. Contudo, um outro desdobramento se mostrou particularmente interessante — e assustador. Os softwares de reconhecimento facial já têm um campo muito claro de experimentação em escala: o da segurança pública.

A vigilância informatizada

Na China, ferramentas de reconhecimento facial já são amplamente utilizadas no âmbito da segurança pública. As incontáveis câmeras espalhadas pelo país contam com a integração em um sistema de softwares sofisticados que possibilitam a identificação e o rastreio dos cidadãos. Hoje, esse tipo de sistema é considerada peça fundamental nas estratégias de segurança pública do país asiático. A interface é capaz de identificar em tempo real com sucesso até 99,5% da população, além de cruzar com outros tipos de dados.

Embora muito mais complexos e sofisticados que os algoritmos das redes sociais ou da câmera do seu iPhone, esses softwares têm um aspecto em comum: para funcionar, isto é, identificar e rastrear rostos, eles precisam de uma sólida base de dados. E é justamente nesse ponto que voltamos para o debate que abri na semana passada e que ganhou corpo durante o fim de semana.

Os problemas com os algoritmos

Os algoritmos não são neutros. Sim, é fato que eles aprendem e “se aperfeiçoam” com o comportamento das pessoas que eles monitoram, potencializando o racismo que se manifesta dentro da plataforma. Todavia, antes mesmo de terem a chance de aprender, esses algoritmos são desenhados, programados e alimentados por uma base de dados.

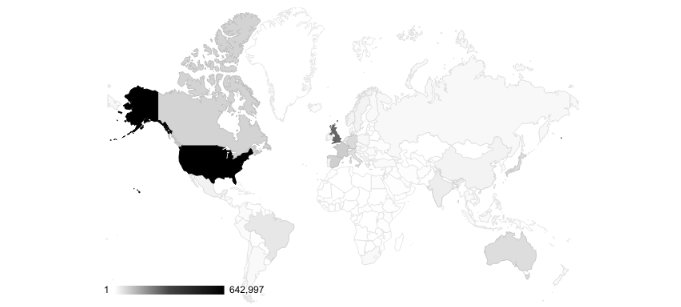

E aí temos o primeiro problema: uma base de dados pouco diversa. Para que as máquinas ou os algoritmos aprendam e sejam treinados, eles precisam de uma larga base de dados. Criar a própria base de dados é um processo custoso, muito caro, de modo que um pequeno número de bases públicas e abertas são amplamente utilizadas para estes fins. Contudo, praticamente todas as imagens que compõem essas bases de dados são oriundas dos Estados Unidos, com uma outra fração de parte da Europa. O artigo “No Classification without Representation: assessing geodiversity issues in open data sets for the developing world” (2017) mostra, além dos problemas de geodiversidade nas imagens das bases de dados, como isso provoca uma classificação/reconhecimento facial absolutamente inconsistente em países cuja maioria da população é racializada, como Etiópia e Paquistão.

A leitura de emoções em programas de reconhecimento facial também é uma realidade. Utilizada em processos de contratação em empresas, esse tipo de ferramenta também pode ser utilizada para identificar potenciais ameaças em meio a multidões. Os resultados também são decepcionantes: rostos de homens negros são frequente lidos como mais “agressivos” e identificados com mais emoções negativas que homens brancos, como mostra a matéria “Emotion-reading tech fails the racial bias test” (2019).

O artigo “Reconhecimento facial e segurança pública: os perigos do uso da tecnologia no sistema penal seletivo brasileiro” (2019) enumera uma série de problemas. Partindo das reflexões sobre encarceramento e genocídio da população negra no Brasil, as autoras, Rosane Leal da Silva e Fernanda dos Santos Rodrigues da Silva, relacionam essas questões com o uso da tecnologia. Durante o estudo, explicam a maneira pela qual os algoritmos dos programas de reconhecimento facial “aprendem” e classificam os dados, identificam padrões, etc. Ao fim do trabalho, o alerta das pesquisadoras é claro: “se não observadas algumas medidas de precaução, o uso de tecnologias de reconhecimento facial automatizado pode colaborar profundamente para o enraizamento do racismo nas estruturas sociais do Brasil”.

A realidade brasileira

Escapando das conjecturas sobre o futuro, o uso desses programas na segurança pública já é uma realidade no Brasil. Com testes iniciados em 2018, as tecnologias de reconhecimento facial no Brasil já produziram um breve e assustador histórico. Cerca de 90,5% dos presos por reconhecimento facial são negros. O artigo de Pablo Nunes, publicado no The Intercept Brasil, trabalha esses dados analisados pela Rede de Observatórios de Segurança, do qual é coordenador.

Além disso, os algoritmos da vida real continuam trabalhando como sempre: há falta de transparência nas informações disponibilizadas pelos órgãos de segurança pública. Como aponta Pablo Nunes, as tecnologias de reconhecimento facial não são mais que atualizações high-tech para a maneira racista como se dão as abordagens, os julgamentos e as condenações nos sistemas judiciário e penal brasileiros, do qual jovens negros são as principais vítimas.

Ainda nesse artigo, Pablo relata casos em que falhas no sistema de reconhecimento facial levaram a abordagens e prisões equivocadas. Parte considerável dos erros cometidos por essas ferramentas é causada pela combinação de bases de dados insuficientes ou pouco diversas e ausência de testagem apropriada. É o que aponta o artigo “Visão computacional e racismo algorítmico: branquitude e opacidade no aprendizado de máquina” (2020), do pesquisador Tarcízio da Silva.

Essa terrível combinação é tanto causa como sintoma do problema. Por um lado, potencializa o racismo já amplamente denunciado das polícias e dos sistemas judiciário e penal, agravando o encarceramento em massa da população negra. Por outro, é sintomático que não haja, na programação desses códigos, os procedimentos necessários para garantir o uso de uma base de dados representativa, ou para assegurar que os algoritmos façam a leitura adequada das informações com as quais se confronta. Quem vigia o algoritmo?

O que esperar?

Mais uma vez: estes códigos não são neutros. O seu comportamento racista não é um mero resultado daquilo que aprende com os humanos que o operam. Antes de aprenderem a ser racistas, os algoritmos são programados para isso, ainda que somente pela omissão. A ampla documentação de como esses programas erram grosseiramente mais quando se trata de imagens contendo pessoas negras não é fruto do acaso.

Num país com políticas de segurança pública claramente marcadas pela perseguição e enclausuramento de pessoas negras e pobres, o que devemos esperar dessas ferramentas? Diante de um governo que cada vez mais interdita o acesso à informação, que tipo de justiça poderemos buscar em relação aos “equívocos” dos algoritmos, sabendo que os próprios algoritmos não são transparentes quanto à sua construção? Além de agravar problemas como o encarceramento em massa, esse novo cenário dificulta qualquer possibilidade de reparação e responsabilização pelas injustiças que já estão e continuarão sendo cometidas. O futuro é desesperador, dentro e fora do mundo digital.

Foto de capa: Emiliano Bar/Unsplash.

LEIA TAMBÉM: Algoritmos da opressão: o dilema das redes é a sociedade que as produz

Historiador pela Universidade Federal do Ceará (UFC), atuando como professor de História. Tem experiência com Patrimônio Histórico e Cultural (SECULTFOR) e estuda trauma em literatura de testemunho na Ditadura Civil-Militar, racismo ambiental e necropolítica. Gosta de música, café e outras artes, tem interesse em temas relacionados à política e cultura e uma paixão inexplicável por aviões.